Machine Learning und Künstliche Intelligenz – Alles nur Hype. (?) Part 3

Willlkommen zu unserem letzten Teil der Reihe zu "Machine Learning - alles nur hype?". Falls Sie die letzten beiden Teile verpasst haben, finden Sie hier Teil 1 und unter diesem Link Teil 2.

In diesem Post beschäftigen wir uns schlussendlich mit konkreten Anwendungsbeispielen.

4 Drei Anwendungsbeispiele

Konkrete Anwendungsfälle sind also gefragt. Aus unserem Portfolio möchte ich hier drei Beispiele aufzeigen, um Ihnen entsprechende Anregungen zu geben. Dies habe ich in drei verschiedene Kategorien aufgeteilt: Einmal ein Beispiel dafür, wie sich bekannte, transaktionsbasierte Analysen verbessern lassen, am Beispiel der klassischen Doppelzahlungsanalyse. Weiter geht es mit neuen Analyseansätzen, und zwar konkret dem Vergleich der Stammdatenqualität, ausgedrückt in einer objektiv ermittelten Kennzahl. Drittes Beispiel ist die Segmentierung von Geschäftspartnern in der Finanzbuchhaltung, allerdings nicht klassisch, sondern basierend auf der Buchungsstruktur, die diese Partner aufweisen.

4.1 Alter Wein in besseren Schläuchen

Eine klassische transaktionsbasierte Analyse ist die Ermittlung potenzieller Doppelzahlungen; also welche Rechnungen oder Gutschriften versehentlich mehrfach gebucht und entsprechend auch bezahlt wurden. Mittels der oben beschriebenen Ansätze lassen sich hier an zwei Stellen Verbesserungen erzielen:

- Unscharfe Analyselogik

- Weniger False positives

Unscharfe Analyselogik klingt erst einmal nicht nach einer Verbesserung. Gemeint ist hier der Umstand, dass basierend auf Datenderivaten als Basis nicht nur exakte Doppelbuchungen ermittelt werden können, sondern auch Buchungen, welche nicht gleich, sondern ähnlich abgebildet sind, denen aber dann der gleiche Geschäftsvorfall zu Grunde liegt, und somit echt Doppelzahlungen sind. Die Möglichkeiten, die sich hier bieten gehen weiter über die üblichen Methoden (Betrag +/- Toleranzwert, Abweichung einzelner Zeichen im Buchungstext, etc.) hinaus.

Weniger false positives zu erzeugen ist dagegen ein offensichtlicherer Vorteil. Die Crux ist, dass einerseits unscharf analysiert werden soll, um eben auch nicht offensichtliche Doppelzahlungen zu finden, die bereits vom SAP System an sich ggf. verhindert werden, sondern komplexer strukturierte. Dies wiederum führt dazu, dass man sich bei konventionellem Vorgehen häufig durch lange Listen an potenziellen Falschbuchungen arbeitet, von denen sich ein hoher Prozentsatz als nicht relevant herausstellt. Unser innovativer Ansatz ist hier, durch maschinelles Lernen Muster in bekannten Doppelzahlungen zu erkennen. Falls Transaktionen diesem Muster in Zukunft ähnlich sind, erkennt dies unsere Software und schlägt Alarm. Die genannten Muster können im Allgemeinen wegen ihrer hohen Komplexität nicht durch Regeln, wie z.B. „wenn Rechnungshöhe größer 1250,49€ und Buchungskreis 0001, sowie Positionstext leer, dann Doppelzahlung“ ausgedrückt werden. Wie bereits erwähnt werden auch Transaktionen erkannt, welche lediglich eine Ähnlichkeit zu bekannten Mustern haben. Dieses Vorgehen kann man sich am besten mit der eingangs erwähnten Bildkollage, welche mein Handy automatisch erzeugt, vorstellen. Das gleiche Gesicht, welches einem Muster aus der Anordnung und Größe von Augen, Ohren, Nase, usw. entspricht, wird auf verschiedenen Bildern erkannt. Der Umstand, dass sich das Gesicht über die Zeit hinweg verändert, oder sich die Perspektiven der Bilder unterscheiden wird durch dies unscharfe Analyselogik abgefangen. Durch das Vermeiden von regelbasierten Analysen passt sich unser Lernverfahren somit zeitlichen Veränderungen bei Doppelzahlungen an, die gefundenen Muster sind also nie veraltet.

4.2 Brandneu

Die Qualität Ihrer Lieferantenstammdaten, in einer Kennzahl ausgedrückt – klingt gut, oder? Mit unseren Analyseansätzen können Sie Ihre Stammdatenqualität mit einem aussagekräftigen KPI nicht nur beschreiben, sondern auch vergleichen – unternehmensintern von System zu System, oder im Zuge von Benchmarkingprozessen mit anderen Unternehmen oder Referenzdatenbeständen. So können Sie direkt ermitteln wo es in Sachen Datenqualität Probleme gibt, und die KPIs auch kontinuierlich monitoren – schließlich wächst das Datenvolumen sekündlich, durch Datenerfassung, Systemmigrationen und Konsolidierungen.

Oder stellen Sie sich als zweites Beispiel Ihren Konzern vor, der die Buchhaltungsprozesse weltweit standardisiert hat. Theoretisch. Und nun möchten Sie die Prozesse auf Homogenität prüfen, allerdings ohne komplizierte Referenzprozesse in ein Process Mining tool zu laden, Event logs zu generieren und dann verschiedene Prozessgraphen zu vergleichen, die wie das Spaghetti Monster aussehen. Stattdessen ermitteln Sie auch hier die Struktur der Buchhaltungsprozesse je Teilkonzern, basierend auf Datenderivaten, einfach in Kennzahlen, die sich dann vergleichen lassen. Durch die Transformation der Prozesse in Zahlen, können einerseits Vergleiche gemacht werden, andererseits werden Prozesse, welche die Homogenität stören, als Ausreißer erkannt.

4.3 Anders

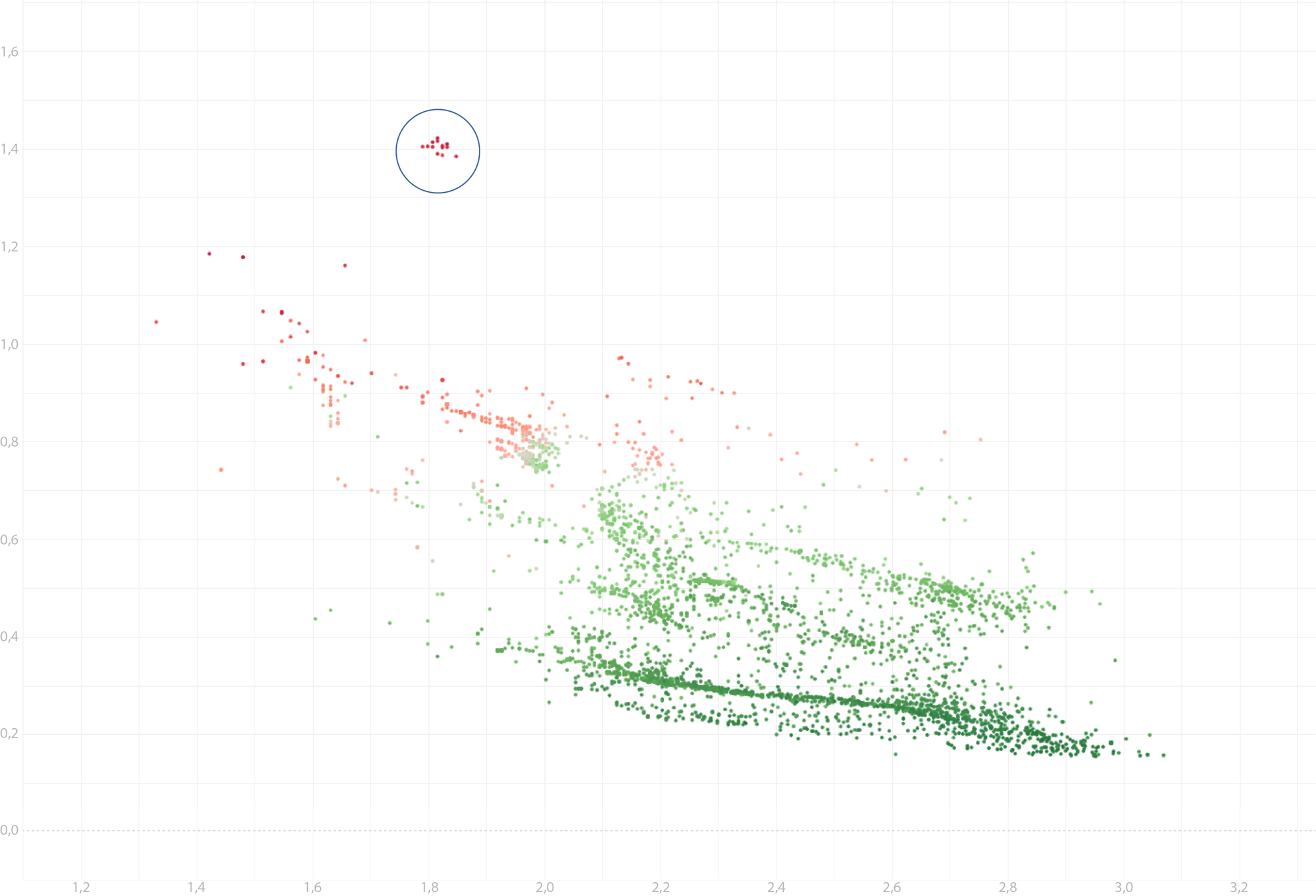

Natürlich haben Sie Ihre Kunden und Lieferanten bereits segmentiert, etwa klassisch mittels einer A-B-C-Klassifizierung, oder ganz einfach anhand einer bereits zugeteilten Kunden- oder Lieferantengruppe, welche praktischerweise bereits als Attribut in den Stammdaten definiert ist. Nun wäre es aber spannend, vermeintlich homogene Gruppen (z.B. alle Rohmateriallieferanten im Inland, die innerhalb Segment A, B oder C liegen) noch einmal basierend auf der digital abgebildeten Geschäftsbeziehung (z.B. rein auf den Buchhaltungsdaten, oder bereits beginnend von den Bestellvorgängen, über Waren- und Rechnungseingänge bis hin zum Zahlungsausgang) zu segmentieren: Werden innerhalb dieser vermeintlich homogenen Gruppe Cluster erkannt, die man hier nicht vermuten würde? Zugegeben, dies geht dann eher in Richtung explorativer Analyse – man muss sich also mit den identifizierten Gruppen anders auseinandersetzen, als man es mit den unter 4.1 und 4.2 genannten Analysen tun würde. Nichtsdestotrotz sind diese Ansätze, die vermeintlich bekannte Aspekte anders aufbereiten spannend, und können von einfachen betriebswirtschaftlichen Erkenntnissen bis hin in den Bereich Fraud Detection zu spannenden Erkenntnissen führen.

4 Fazit

In diesem Blogpost haben wir verschiedene Themen zum Teil gestreift, zum Teil etwas tiefergehend betrachtet. Wenn Sie sich mit Datenanalyse beschäftigen (bzw. schon Erfahrung in diesem Gebiet haben) finden Sie hoffentlich Anknüpfpunkte zu Ihren bisherigen Ansätzen. Wenn Sie sich erst seit kurzem mit diesem Thema befassen, oder direkt mit neuen Ansätzen wie Machine Learning einsteigen, finden Sie vielleicht einen kleinen Praxisnahen Leitfaden, wie Sie sich dem Thema nähern können (Geeignete Daten identifizieren, mit den richtigen Methoden transformieren und dann mit klaren, erreichbaren Zielen vor Augen die geeigneten Algorithmen anwenden). Die technischen Hilfsmittel sind vielfältig und an anderer Stelle besser zu finden – hier war der Schwerpunkt auf dem methodischen Vorgehen. Wenn Sie Kunde von uns sind (oder werden möchte, was uns natürlich freuen würde) haben Sie das klare Signal, dass wir passend zu unserer Vision „Datenanalyse zu einer Selbstverständlichkeit machen“ auch die aktuell im Hype Cycle so angesagten Themen wie Künstliche Intelligenz und Machine Learning im Portfolio haben. Personell sind wir dafür mit unserem Team, welches wir entsprechend um Data Scientists erweitert haben, ebenfalls bestens aufgestellt. Wir helfen, den Kreis zwischen klassischer Datenanalyse und den neuen Methoden zu schließen, um unseren Kunden auf dem Weg zur Digitalisierung eine integrierte Lösung zu bieten.